日付;2023/09/10(日)

最近、どうやらChatGPTが注目されている。GPTはGenerative Pretrained Transformerの略らしい。Wikipediaによれば、2022年11月30日に、OpenAIがChatGPTを公開したらしい。その直後から、Natureとかに記事が載っている。きっとかなりの革新なんだろう。そういうことなので、この記事は科学研究や教育におけるLLMの利用に着目して書いた。機会があれば、ビジネス分野ではどんなふうに考えているか勉強しようと思う。

使ってみる。

どれだけの物か、ちょっと使ってみた。入力した文は以下である。

Prepare abstract of scientific paper describing “ethcal aspect of using chatGPT on scientific paper writing”.

Default (GPT-3.5)

出力された文がこれ。

Title: Ethical Considerations in the Use of ChatGPT for Scientific Paper Writing

Abstract:

The integration of artificial intelligence (AI) technologies, such as ChatGPT, into scientific research and writing processes has demonstrated promising potential in enhancing efficiency and creativity. ChatGPT, powered by the GPT-3.5 architecture, is an advanced language model capable of generating coherent and contextually relevant text. However, as researchers embrace this innovative tool for scientific paper writing, ethical considerations surrounding its application become paramount.This paper addresses the ethical implications of utilizing ChatGPT in scientific paper writing. The key ethical concerns center on authorship, plagiarism, and bias. While ChatGPT can provide valuable assistance in generating content, the attribution of authorship for the generated text poses a complex challenge. This raises questions about intellectual property rights and recognition for human contributions versus AI-generated content.

Additionally, the risk of unintentional plagiarism arises when researchers use ChatGPT to produce sections of their scientific papers. The AI’s vast knowledge base could inadvertently reproduce text from existing publications, potentially leading to issues of academic integrity and credibility. As such, proper attribution and verification mechanisms should be implemented to ensure that AI-generated content adheres to ethical standards.

Furthermore, the potential for perpetuating bias is an ethical concern in deploying ChatGPT. The model’s learning data might contain biases present in the source material, leading to the reinforcement of social, gender, or cultural biases in the generated text. Consequently, researchers should be vigilant in critically reviewing AI-generated content and striving to ensure its neutrality and objectivity.

This paper advocates for a comprehensive ethical framework to guide the ethical use of ChatGPT in scientific paper writing. Emphasis is placed on transparency, disclosure, and clear indication of AI-generated text within the manuscript. Collaborative efforts between AI developers and the scientific community are necessary to address these ethical dilemmas, foster responsible AI implementation, and maintain the integrity of scientific research.

In conclusion, while ChatGPT offers a powerful tool for scientific paper writing, careful consideration of ethical implications is imperative. By establishing ethical guidelines and fostering an environment of openness and accountability, researchers can harness the full potential of AI while upholding the highest ethical standards in scientific communication.

Default (GPT-3.5)

は??本気なんですか???もはや人間が考えるより、このChatGPTのような「大規模言語モデル(Large Language Model; LLM)」というやつを使ったほうが、自分だけで何かを考えるよりも仕事を終わらせるのが早いんじゃあないのだろうか。でも、色々と記事を読んでいると、意見が随分と割れているように思うし、ポジティブ側とネガティブ側の意見の内容が完全に真逆である。両者とも至極全うな意見を述べている。このソフトとアカデミックな活動においてどのように付き合っていくべきなのか理解するためにも、色々と記事を読み、どんなことならやって良くて、何をやったら駄目なのか自分なりに答えを出そうと思う。

大まかなメカニズム

重要なことだが、ChatGPTを始めとするLLMを利用したソフトは内部で何を行っているのか理解する必要がある。これらは、入力された質問と、トレーニングデータセットの中の統計的な相関が高い単語を選び、それを統計的に尤もらしい並びに変えて出力する、という計算を行うようだ。トレーニングデータセットの大きさはソフトによって違っており、また、トレーニングは利用者や研究者のフィードバック(要は出力の成否のフィードバック)により成される。この計算により、人間が書いたと見紛うほどの文章が出力される。そして、ここが賛否両論の原因である。

問題点

盗用(Plagiarism)になり得る。

個人的に、これをやったら直接的に研究のキャリアは終わるだろうなってところである。なぜ盗作が起こり得るかといえば、それはLLMが大きなトレーニングデータセットの情報を、ライセンスを持っている出版社などの承認を得ず、引用などもしないで出力するためである。出力された文章や画像(その他のGenerative AIによる)は、元のデータの一部だけが使用されることも多く、そのような文章や画像のほんの一部だけの利用に関して、著作権などでどう対応するのか、あまり固まっていないようだ。そのため、2023年の時点では、出力された文章や画像を大っぴらに利用することは、盗作の可能性がある、という理屈のようだ。確かに。これを使って作成した文章で論文を出して、あとから盗用とか言われたけど、自分には思い当たる節はないが、「あ、でも全部ChatGPTに投げたヤツだわ。」みたいなことになるってことである。既にStable DiffusionやMidjourneyといったいくつかのAIソフトや、マイクロソフトとOpenAIもCopilotでの海賊行為として起訴されているらしい。

情報漏洩になる可能性がある。

これも非常に不味い問題である。こちらが入力した情報は、LLMのトレーニングデータセットとして企業のサーバーのどこかに保存され、大量のデータの中に埋もれ、そして全く意図しないところで何処かの誰かに出力される可能性がある(たぶん)。そして、LLMを開発している企業のサーバーには、事実としてそのようなデータが残っており、その企業は場合によってはそのデータを利用できるということである(たぶん)。Pythonのコードを入力しても同じことが起こる。例えば、”Please correct this python code for actually working for”とか、”Which is a part having bag in following python code?”とかで、実際に自分の書いたpythonコードを入力した場合なんかがそうである。何をしようとしているかわかるし、場合に依ったら利用されてしまうかもしれない。これは、企業側が「入力された情報は、企業のサービス向上のために使用します。」とかそういうこととは別である。そのデータがトレーニングデータセットや出力のための辞書的なデータセットに保存されている以上(詳しくは知らんけど)、ソフトが出力してしまう可能性もある。現時点では、まだ危ない。生データとか命や金や生活に関わる個人情報とかの入力は絶対にやってはいけない。

事実ではない。

前述の通り、LLMは入力した質問をトレーニングデータセットに照らし合わせ、統計的に尤もらしい回答と文章を出力する。上述の著作権や引用の問題と同じように、その出力の事実関係や正しさは検証しないようだ。なので、回答のないことに対してフィクションを出力する可能性がある。これをこの分野の用語でHallucinationというらしい。すなわち、実際は起こったこともないようなことを、まるで本当の出来事のような話を作ってしまうということらしい。LLMのソフトはどうやらTuringテスト(質問者が回答者を人なのかコンピューターなのか判断するテスト)をクリアしてしまっているようなので、そういう統計的な作り話をスムーズに語られるでもしたら、その分野に詳しくない場合は間違って受け取ってしまいそうだ。内容が事実では無いことは、科学にとってみれば致命的であると思う。

正確ではない。

単語と単語を結びつけて上手に出力することに主眼が置かれているので、もちろん出力の正しさは検証されていない。これは上述の事実関係と同様のメカニズムによる。どちらかといえば、並べられた単語(例えば、タンパク質の種類)と、その関係性について、単にタンパク質の種類を入力しただけで正しく述べることができるか、ということである。もちろん、そのタンパク質同士の関係性がトレーニングされていれば、正しいことをかけるだろうが、それ以外には正しく解釈できるとは思はない。ちょっと別の問題としてHalo効果ということもあるらしい。これは、一部の結果や事例だけで、その現象や事例を過剰に一般化してしまう傾向を起こすような効果らしい。過大評価や飛躍した解釈による本質のミスリードである。こういったことが起こってしまうもう一つの理由として、トレーニングで関連性の高い文献を参照していないために起こっていることなどもあるようだ。また、最近はTheory of mindについても含めることが出来るようになってきているようだが、やはり、人間のそれには全く敵わないようだ。

差別的なことを出力する場合がある。

これは特にMetaの開発するGalacticaで起こったらしい。これは他のLLMを組み込んだソフトでも起こるらしく、例えば、歴史的な事例から差別的な文章を出力する場合があるらしい。地理的(国)にも、性別的な問題も引き起こしかねないようだ。これは、単語の尤もらしい組み合わせの出力だけでは、事実関係や信頼性を担保できないということにも繋がっていると思う。あと、このChatGPTなどが、主に英語圏を想定して作製されていることも問題として挙げられるようだ。つまり、他の言語ではロクに出力できなかったりする。こういったことをひっくるめて「バイアスがある」と言われている。

その他の問題(乱用による誤った情報の拡散・多様性低下・オリジナリティー低下)

これらは誤った使い方の末路であると言える。乱用による誤った情報の拡散、内容の多様性とオリジナリティー低下に関しては、直接に証拠を示す文献なんかは見つけることができなかったが、最終的に行き着く結末としてなんとなくわかる。おそらく、これらはGoogleやSNSにも見られる現象だと思うが、LLMを実装したソフトでその影響が強く出てしまう可能性が考えられる。すなわち、ChatGPTが誤った内容を学習し、それらが更に他の誰かに使用されてしまい、その誤った内容に良いスコアが与えられるということの繰り返しが起こることが原因なんだろう。これを乱用することで間違いだらけの文章や単語の並びが多く出力されてしまうということである。それに加えて、上述の通りChatGPTは内容の正しさや事実関係を確認することは出来ない。確認を怠っているユーザー、出力結果を正すことができない専門家以外のユーザーが、それらを怠って文字通り乱用した結果が誤った情報の拡散である。

そして、Harvard Business Reviewの記事に書いてあった(これらは別にポストしようと思う。)のだが、ChatGPTを使う一つの目的が手抜きであり、これが多様性やオリジナリティーの低下を引き起こすことが考えられる。これもその根拠を示す文献を読んだわけではないので想像ではあるが、インターネット上の情報を確認しているとそれが読み取ることができる。例えば、大学のレポートでの例である。学生はまだ知識を持った専門家ではない。というか、知識を持った専門家なんて、博士課程とポスドクを経験してやっと身につくようなものである。そういう奴がChatGPT使う目的が、レポートを早く片付けるという、つまりは手抜きである。そのためにChatGPTや他のLLMを組み込んだソフトを使った結果、使った人のレポートが全部似た内容だったということである。これがつまり多様性やオリジナリティーの欠如である。世の中、流行りや一般論ということがあるので、ある程度似てくるのは解るが、おそらくこれが誤った方向性で起こり、その誤りの広がりが非常に早いとうところがマズいのだろう。

代表的なジャーナルではどのように取り扱っているか。

この記事を書くためにいくつかの記事を読んだ。確か、Nature、Science、Lancetだったと思う。特にChatGPTを始めとするLLMを組み込んだソフトにネガティブなのがScienceである。ScienceではChatGPTは基本的に難色を示しており、「もしChatGPTを使う場合は、論文中にその旨についてちゃんと書け。そうしなければ盗作と見なす場合もある。」と考えているようだ。また、ChatGPTがいくら文章を生成できるからと言って、著者としても認めていない。既にいくつかの(非常にマイナーで怪しい)論文に、著者のところにこのソフトが述べられているものもあるようだ。しかし、そのうちのある論文誌では、それはいずれ訂正されなければならないと考えているらしい。当然だが、このようなソフトやプログラムを著者として並べることは出来ない。その理由は、それらはその論文の内容について責任を負うことが出来ないためだ。

Natureなどでは、記事を読んでいる限りでは、かなりしっかりと議論がされているように見えた。Natureでは基本的にSicenceと一緒であり、使用についてはMaterials and Methodsのセクションに利用について記載するか、どこかにAcknowledgeする必要があり、論文の責任を取ることができないので著者に並べることは出来ないということは共通している。現在、色々なコミュニティーに働き書けて、ポリシーを固めているところのようだ。Sicenceとの違いは、Natureでは結構ポジティブにとらえていると読めることである。この技術を禁止(Ban)するのは現実的ではない。だって既にウェブブラウザやウェブサービスに取り入れられているし、今後もどんどん発展する。だから、ジャーナルとしてちゃんとポリシーを立てる必要がある。ということらしい。

助成金申請で認められるか。

ある意味ではこれが非常に重要なことだと思う。どうやら、NIHはChatGPTを始めとするGenerative AIの使用を禁止したらしい。NIHとしては、データがどこに送られていて、どうやって保存されていて、将来的にどのように使用されるかわからないし、アイデアに関するオリジナリティーがなくなり、盗作にさえなり得ると考えているらしい。オーストラリアでも科学でのGenerative AIは禁止されているようだ。

正直に言えば、上述のScienceとこのNIHの禁止で答えが出た感がある。すなわち「科学研究では使うな。内容の正確性(Integrity)を担保することは難しく、使ったとしてもその元のデータセット(つまり、ツールとしての)透明性(Transparency)が欠如しており、正直(Honest)かどうかもわからん。」って感じである。やっぱりそうなってしまうか…

アカデミックではどのような使い方が良いか。

次に、大学(教育も含む)や研究所で、どうやってLLMと付き合っていったら良いか個人的な考えを述べる。

まずはGoogleくらいに使い方を覚えること

あとにも先にもこれが最も重要ではないかと思う。Natureに大学で教えていることとして以下が書いてあった(参考文献9)。日本の大学も、明確な目的を持ってLLMの「一般的な利用」を教育できているところや、研究に関するポリシーを打ち立てているところはあるのだろうか。無いだろう。だって日本の研究所はレベルが低いから。

- 質問を変えてみる。盗作(Plagiarism)を避けるように。

- 平等性がなくなる危険性に気づく。そして学校の課程で自分で考えることができるようにする(オリジナリティーを出すように)。

- ChatGPTで何を知りたいのか、明確なゴールを示す。

- プロンプトを試して改善する。バイアスを正す。

- 他の人と同時に作業する。先生と生徒など。プロンプトとレビューを改善する。

日本の大学や研究機関にはもはやこういうことを指導する力は無いので、自分で習得する必要がある。研究を行っている者、これから行おうとしている学生ならば、絶対にその使い方を理解して、その分野にとってどのような使い方が良いのか検討しておくのが絶対に良い。Natureと同じ考え方で、こういったテクノロジーを禁止することは、不可能であり、逆にどんどん発展する。それに対応する必要があるし、対応できないデジタルリテラシーの低い人間はどんどん遅れていくのは明らかである。

知らない単語の用法をざっくりと知る。

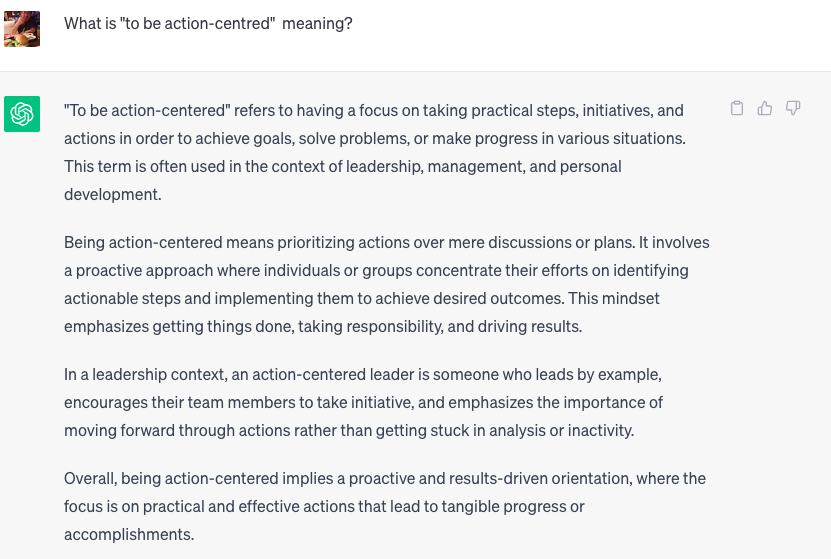

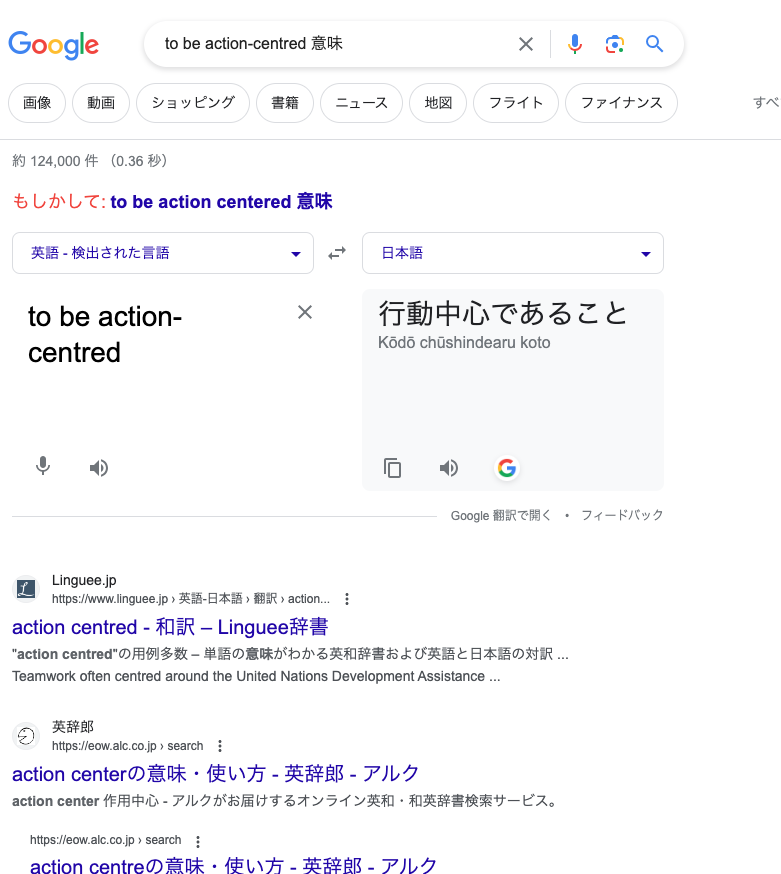

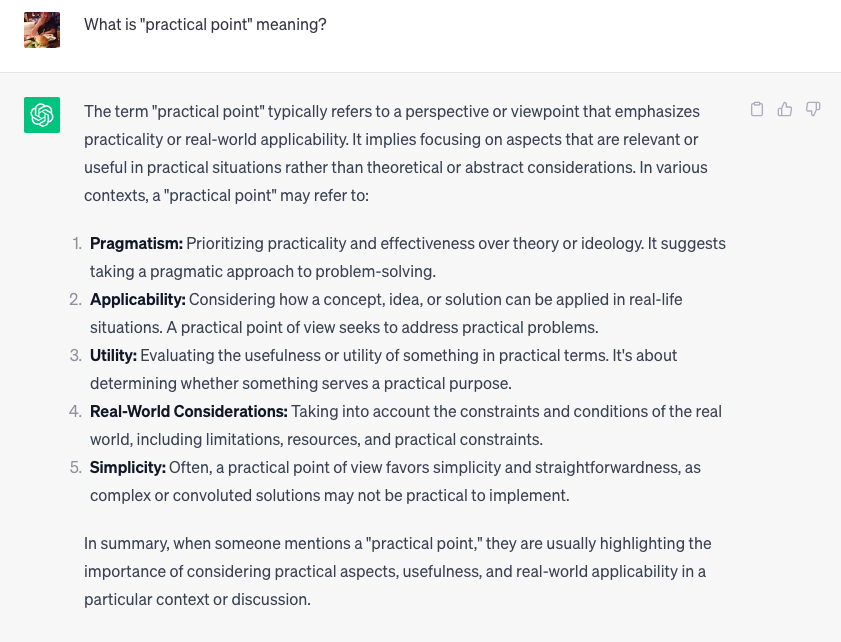

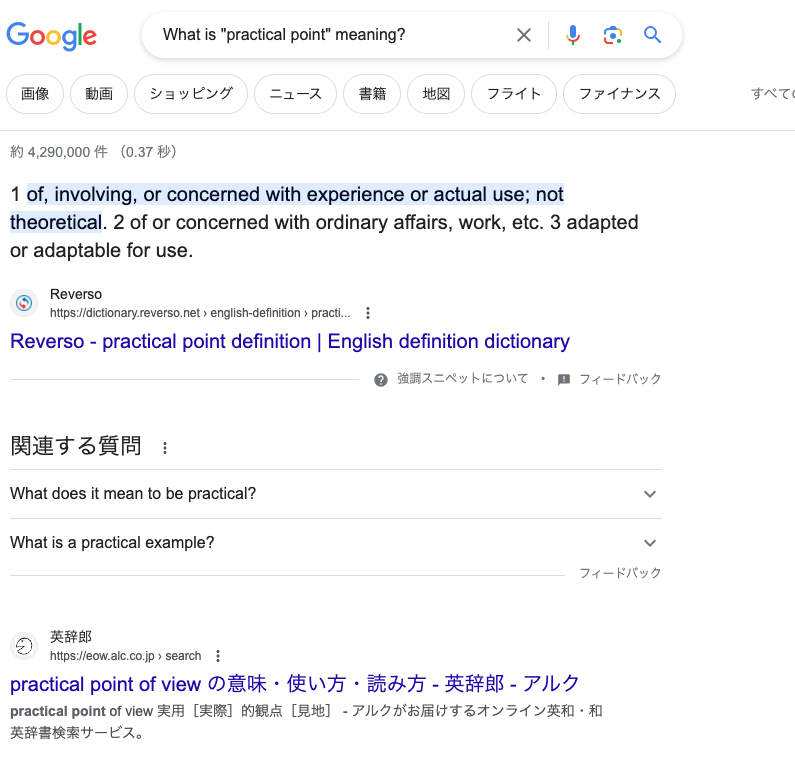

ここではChatGPTについて述べる。個人的にGoogleより優れている点として、やはり要約してくれることである。正直、英語の文章を要約したり翻訳したりするのは、研究者や学生として失格であると思っている。これは後で述べるとする。しかし、異なる分野での単語やフレーズの使い方やその意味するところをChatGPTに聞く分には非常に便利と思っている。Googleでは、まさにその単語の意味「だけ」がで表示される。英語やフレーズの意味なんてのは、場合や分野に応じて変わるものであるので、あまり参考にならない。例えば、Googleに「Throw off 意味」と入力したときに返ってきた結果と、ChatGPTに「What is “throw off” meaning?」と入力したときの結果は、明らかにChatGPTの方がほしい情報に近い。Googleの結果は、現時点ではChatGPTの結果に至るためには自分で更に色々と調べる必要がある。しかもGoogleの悪い点として、ユーザーの関心に基づいたランキングっているロクでもない順番で表示してくることがある。SEO対策が完璧だと、まるでゴミのような情報やあまりにも陳腐でどこのウェブサイトのコピーペーストみたいなサイトがトップにくる、とか、公式ホームページがどこに表示されているかわからないとかの、それである。単語の意味くらいなら影響はないが、もうちょっと複雑なフレーズの用例や意味的な背景になるとほとんど役に立たない。このChatGPT関係の文献を調べていても、”Practical point”や”Acton centered”などのようなビジネス関係の何言ってっかわからん用語については一般的な用例であればChatGPTはかなり便利だった。こういう使い方は個人的には有用だと思う。

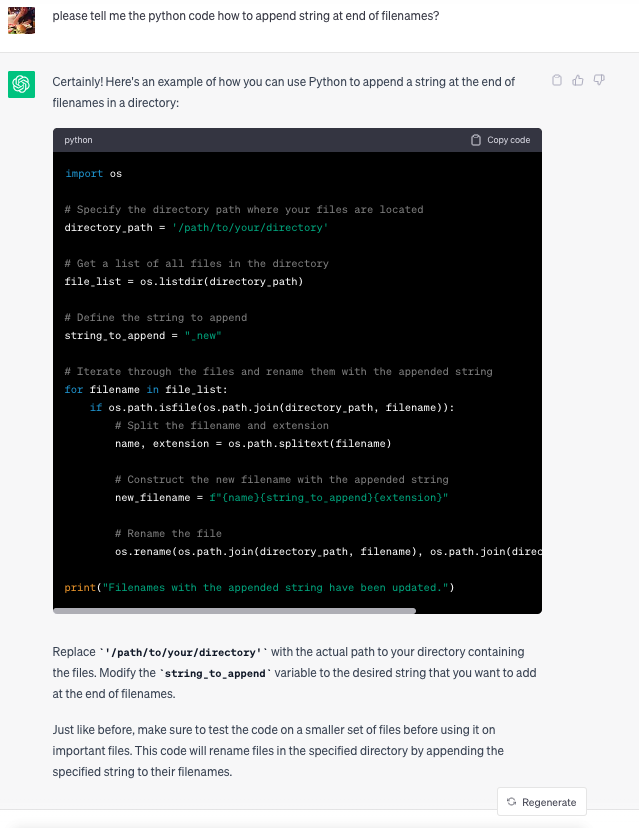

コードを調べる。

自分は修士くらいからRを使ってきていて、Rならば、必要最低限の解析はほぼできるのでは無いかと思っている。しかし、Pythonがまだあまり良くわかっていない。もう、Rを使ってきた慣性で使えているようなものであり、けっこう基本的なことでもつまずくことがある。そんなときにGoogleに聞いてみても、本気で役に立たない、書いた本人も使っていないんじゃあないかと思うくらい無駄なブログとかウェブサイトにしか行き着かない。結局、公式ホームページのAPIを見たほうが、早いという体たらくである。しかし、ChatGPTに”please tell me the python code how to append string at end of filenames?”とか聞いたら、本当に動くコードが返ってくる。さすが、コンピューター言語のネイティブスピーカーのことはある。これについてはライブラリの公式ホームページからAPIを調べるよりも圧倒的に用事を片付けるのが早い。そういえば、クレイトン・クリステンセンのノベーションのジレンマでも、用事を片付けることが出来るモノが破壊的なイノベーションにつながるって書いてあった。まさにそれである。とにかく、Googleで検索するよりも圧倒的に早く目的の情報にたどり着くことができる。

その他の雑用

これはもうどこでも言われていることだが、情報漏洩、情報の正確性、正直さに影響しないような仕事なら、正直なところ、全部ChatGPTで良い。例えば、朝のスピーチ。誰も聞いてないから。時事に関係する単語やフレーズと、抱負なんかを適当にChatGPTに放り込んでやれば良い。多く見積もって30分もあればこんなゴミみたいな仕事は終わるだろうと思う。

学生や研究者としてやらない方が良いこと

将来に渡って、アカデミックや他の企業なんかでもやらない方が良いだろうと思うことが以下である。ここに書いてあること以外でも、要は自分の能力やアイデアを将来に渡って制限してしまう可能性がある行為は避けたほうが良い。

知らない分野での利用は避けること。

もしかしたら、これはしっかりと意識する必要があるかもしれない。やはり、ChatGPTの利点の一つに、その分野の専門家では無い者や、知識の無い者の仕事の効率を著明に上げる、ということがある(https://news.mit.edu/2023/study-finds-chatgpt-boosts-worker-productivity-writing-0714)。例えば、英語が得意ではない人間が英語のメールやアブストラクトを書く、という具合である。しかし、一方で、事実無根の内容を出力したり、内容に正確性が欠如していたり、著作権の違反をしたりする欠点もある。効率を上げるより、著作権を違反したり、盗作や捏造をしてしまうリスクのほうが、アカデミック(教育や研究)では明らかに危険である。

また、前述のように、疎い分野でこれを多様し、自分で学んだり出力したりすることをやめてしまった場合、アイデアや作成した資料にオリジナリティーや多様性がなくなってしまい、いざというときにアウトプットできなくなってしまう。そうなると、一体その人はなぜ勉強しているのか、なぜ研究しているのかわからなくなってしまう。

そういうことなので、詳しくない分野での効率を上げるからと言って、詳しくないのにそれを使ってしまうことこそ、あまり良くないことに繋がってしまうと言える。

要約を出力しそれを利用すること。

これは各分野でおすすめされている使い方であるが、とかくオリジナリティーやデータの正確性が必要な分野ではどうやら駄目っぽい。Scienceでは、単なるサマリーと、適切なレビュー(展望や考え(インサイト)を加えること、批評、評価、専門的なアセスメント)は大きく違うと考えているようだ。つまり「いくら要約を作ることが出来るとっても、その解釈には専門性が必要なので、やるなよ。」という意味なんだと思う。

あと、これは上述した内容と重なるが、やはり、自分で考えて何か生み出す力(考えるプロセス、手順、方法)、潜在的な問題やリスクを見つけて解決する力、学生ならば英語のスキルや凡例などの学習などが出来なくなってしまう。考えてみればこれは怖いことである。修士課程の2年、さらには博士課程の3年、合計5年間もそういうことをやってしまった奴なんかと、一緒に仕事なんか出来るわけない。絶対に使えない人間に仕上がるに決まっている。

だからと言って、それを全く使うなと言っているわけではなく、上手に使って効率を上げろ、ということを言いたい。ただし、リスクやその分野のことを全部勉強した後にな。学生ならば最初のうちに全部自力でやって、内容だけでなく調べる能力も鍛える必要がある。研究者でこれやる奴はゴミである。

箇条書きから文章やプレゼンテーション資料を出力すること。

個人的に全く理解できないのが、箇条書きからプレゼンの資料を出力したり、文章に起こしたりする方法である。

専門家だろ??専門家でなくても、それを生業としてるんだろうが。だったら自分の能力で正確な資料を与えられた時間内に作成したらどうだ?というか、それを自分でやるほど仕事に興味がないのであれば、その仕事はすぐ辞めて、他の誰かに席譲れよ。

これをやってしまった時点で、その仕事のクオリティーは信頼性なくも出典先も記載されていないゴミのようなブログにまで落ちる、ということだ。

LLMを組み込んだ他のソフト

以下がChatGPTの他のソフトである。

- Elicit (https://elicit.org/)

- Sparrow (DeepMind) (https://www.deepmind.com/)

- Anthropic (https://www.anthropic.com/)

- Galacitca (Meta)

- Bloom (https://github.com/dptrsa-300/start_with_bloom)

- Med-PaLM (https://sites.research.google/med-palm/)

以下が検出ソフトである。ただし、どのくらい使えるかは不明。使ったことないので。

- GPTZero (https://gptzero.me/)

- Turnitin (https://www.turnitin.com/ja/ai-writing/about-ai-writing-detection)

まとめ

ChatGPTを始めとするLLMを使ったソフトは、Googleを凌駕するくらい凄い。しかし、ソフトウェアが出力する内容の事実関係、正確性、出典などを検証しないため、出力内容を信じるのは現時点では難しい。Scienceでもその使用は禁止していないものの、オススメしていない。そういうことなので、大学や研究所などのアカデミックでのChatGPTの使用は注意する必要があり、かつ限定的と言える。使ったとしても、その出力の正確性、正当性、透明性、正直さをどうやって担保するか考えなればならない。使用時にはChatGPTを始めとするLLMを組み込んだソフトを使用した旨をMaterials and Methodsなどに明記する必要がある。また、ソフトウェア自体が責任を取ることが出来ないので著者として並べることはできない。重要なこととして、NIHなどはその使用を認めておらず、場合によれば盗作になると言っている。これを考えると、これらのソフトウェアのアカデミックでのScientific Writeing(大学のレポート作成、論文作成や助成金作成)には使用することができないと言える。

この点についてはNatureはけっこうポジティブに理解しているように見えており、彼らはそれらの使用を禁止することはもはや現実的ではなく、科学研究を正直で正確なものにするためにはポリシーを決める必要があると言っている。実際、その有用性はかなり高く、単語やフレーズの一般的な用法や意味や、プログラムのソースコードのヒントを得るためにはGoogleに比べて明らかに便利であり、使用しないという手段はないよう思える。

だから、今後はアカデミックやインダストリーを問わず、このようなテクノロジーの有用な使い方と、何が出来て何が出来ないのかを学ぶ必要があり、教育では特に若い学生たちにこれらを教える必要がある(出来るものならやってみろよ日本の研究機関)。そうしなければ、このようなテクノロジーを使えない人間はどんどん遅れていってしまうだろう。

参考文献

この記事は以下の記事を読んで、自分なりに理解したことを書いている。興味があれば、読んでみたら良いと思う。Scienceの記事は勉強になった。特に、3、4、5、13、14は研究者なら一度読んだほうが良いと言える。研究者ならば、この中では3と18は必須である。また、16、17、20についてはGenerative AIのベンチマークについて書いてあり、今後、どのようにこれらのツールを使えば良いか考える良い刺激になった。ベンチマークにおけるコンタミネーションってのもなかなか面倒な問題であると思う。

- Else, H. Abstracts written by ChatGPT fool scientists. Nature 613, 423 (2023). https://doi.org:10.1038/d41586-023-00056-7

- Stokel-Walker, C. ChatGPT listed as author on research papers: many scientists disapprove. Nature 613, 620-621 (2023). https://doi.org:10.1038/d41586-023-00107-z

- Thorp, H. H. ChatGPT is fun, but not an author. Science 379, 313 (2023). https://doi.org:10.1126/science.adg7879

- van Dis, E. A. M., Bollen, J., Zuidema, W., van Rooij, R. & Bockting, C. L. ChatGPT: five priorities for research. Nature 614, 224-226 (2023). https://doi.org:10.1038/d41586-023-00288-7

- Stokel-Walker, C. & Van Noorden, R. What ChatGPT and generative AI mean for science. Nature 614, 214-216 (2023). https://doi.org:10.1038/d41586-023-00340-6

- Stokel-Walker, C. AI chatbots are coming to search engines – can you trust the results? Nature (2023). https://doi.org:10.1038/d41586-023-00423-4

- Tregoning, J. AI writing tools could hand scientists the ‘gift of time’. Nature (2023). https://doi.org:10.1038/d41586-023-00528-w

- Ebrahimi, B., Howard, A., Carlson, D. J. & Al-Hallaq, H. ChatGPT: Can a Natural Language Processing Tool Be Trusted for Radiation Oncology Use? Int J Radiat Oncol Biol Phys 116, 977-983 (2023). https://doi.org:10.1016/j.ijrobp.2023.03.075

- Yang, H. How I use ChatGPT responsibly in my teaching. Nature (2023). https://doi.org:10.1038/d41586-023-01026-9

- Cacciamani, G. E., Collins, G. S. & Gill, I. S. ChatGPT: standard reporting guidelines for responsible use. Nature 618, 238 (2023). https://doi.org:10.1038/d41586-023-01853-w

- Wang, S. H. OpenAI – explain why some countries are excluded from ChatGPT. Nature 615, 34 (2023). https://doi.org:10.1038/d41586-023-00553-9

- Baker, N., Thompson, B. & Fox, D. ChatGPT can write a paper in an hour – but there are downsides. Nature (2023). https://doi.org:10.1038/d41586-023-02298-x

- Lenharo, M. ChatGPT gives an extra productivity boost to weaker writers. Nature (2023). https://doi.org:10.1038/d41586-023-02270-9

- https://news.mit.edu/2023/study-finds-chatgpt-boosts-worker-productivity-writing-0714

- Conroy, G. Scientists used ChatGPT to generate an entire paper from scratch – but is it any good? Nature 619, 443-444 (2023). https://doi.org:10.1038/d41586-023-02218-z

- Biever, C. ChatGPT broke the Turing test – the race is on for new ways to assess AI. Nature 619, 686-689 (2023). https://doi.org:10.1038/d41586-023-02361-7

- ChatGPT is a black box: how AI research can break it open. Nature 619, 671-672 (2023). https://doi.org:10.1038/d41586-023-02366-2

- Kaiser, J. Funding agencies say no to AI peer review. Science 381, 261 (2023). https://doi.org:10.1126/science.adj8309

- Mitchell, M. How do we know how smart AI systems are? Science 381, adj5957 (2023). https://doi.org:10.1126/science.adj5957

- The Lancet Digital, H. ChatGPT: friend or foe? Lancet Digit Health 5, e102 (2023). https://doi.org:10.1016/S2589-7500(23)00023-7